แอปเปิล ประกาศเปิดตัวคุณสมบัติตัวช่วยการเข้าถึงใหม่ๆ ที่จะพร้อมใช้งานภายในปีนี้ ซึ่งรวมถึงการติดตามดวงตา (Eye Tracking) ที่จะช่วยให้ผู้ใช้ที่มีความบกพร่องทางร่างกาย ควบคุม iPad หรือ iPhone ได้ด้วยการใช้ดวงตาเพียงอย่างเดียว

ค่อนข้างจะเซอร์ไพรส์ ด้วยการเปิดตัวคุณสมบติใหม่ๆ ก่อนงาน WWDC 24 ที่จะจัดในเดือนมิถุนายนที่จะถึงนี้ ด้วยเทคโนโลยีสุดล้ำที่ออกแบบมาสำหรับทุกคน โดยเฉพาะผู้ที่มีคามบกพร่องทางร่างกาย เนื่องในโอกาส เฉลิมฉลองวันตระหนักรู้ถึงการเข้าถึงอย่างเท่าเทียม Global Accessibility Awareness Day (GAAD)

คุณสมบัติเหล่านี้เป็นการผสมผสานพลังของฮาร์ดแวร์และซอฟต์แวร์ของ Apple เข้าด้วยกัน พร้อมการใช้ประโยชน์จาก Apple silicon, ปัญญาประดิษฐ์ (AI) และการเรียนรู้ของระบบบนอุปกรณ์ เพื่อยกระดับคำมั่นสัญญาที่ Apple ยึดมั่นมาอย่างยาวนานหลายทศวรรษในการออกแบบผลิตภัณฑ์สำหรับทุกคน

“เราเชื่อมั่นอย่างลึกซึ้งว่านวัตกรรมมีพลังในการเปลี่ยนแปลงที่จะสามารถเติมเต็มชีวิตของผู้คนได้” Tim Cook, CEO ของ Apple กล่าว “นั่นเป็นเหตุผลที่ Apple สนับสนุนการออกแบบที่ครอบคลุมโดยการใส่ความสามารถด้านการเข้าถึงไว้ในแกนหลักของฮาร์ดแวร์และซอฟต์แวร์มาเป็นเวลาเกือบ 40 ปีแล้ว เรายังคงผลักดันขอบเขตของเทคโนโลยีอย่างต่อเนื่อง และคุณสมบัติใหม่ๆ เหล่านี้ได้สะท้อนให้เห็นถึงความมุ่งมั่นอันยาวนานของเราในการมอบประสบการณ์ที่ดีที่สุดเท่าที่จะเป็นไปได้ให้กับผู้ใช้ทุกคน”

“ในแต่ละปี เราได้สร้างมาตรฐานใหม่ๆ ให้กับการเข้าถึง” Sarah Herrlinger ผู้อำนวยการอาวุโสฝ่าย Global Accessibility Policy and Initiatives ของ Apple กล่าว “คุณสมบัติใหม่เหล่านี้จะสร้างผลกระทบให้กับชีวิตของผู้ใช้หลากหลายกลุ่ม โดยการมอบวิธีใหม่ๆ ในการสื่อสาร การควบคุมอุปกรณ์ของพวกเขา และการใช้ชีวิตในโลกใบนี้”

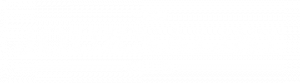

Music Haptics ฟังเพลงด้วยการสั่น

นอกจากนี้ Music Haptics ยังเปิดโอกาสให้ผู้ใช้ที่หูหนวกหรือมีปัญหาในการได้ยิน สามารถเพลิดเพลินกับเสียงเพลงในรูปแบบใหม่โดยใช้ Taptic Engine ใน iPhone ซึ่งฟังด้วยการแตะพื้นผิวและการสั่นที่ปรับแต่งให้กับเสียงเพลง ใช้งานได้กับเพลงหลายล้านเพลงในแอป Apple Music และจะพร้อมใช้งานเป็น API สำหรับนักพัฒนาเพื่อทำให้เสียงเพลงเข้าถึงได้มากขึ้นในแอปของพวกเขา

รวมถึง Vocal Shortcuts ช่วยให้ผู้ใช้ iPhone และ iPad กำหนดคำสั่งเสียงพูดที่ Siri สามารถเข้าใจได้ในแบบของตัวเอง เพื่อเปิดใช้งานคำสั่งลัดและทำงานที่ซับซ้อนให้สำเร็จได้

Listen for Atypical Speech เป็นอีกหนึ่งคุณสมบัติใหม่ที่ช่วยให้ผู้ใช้มีทางเลือกในการปรับปรุงการจำเสียงพูดสำหรับรูปแบบเสียงพูดที่หลากหลาย โดยจะใช้การเรียนรู้ของระบบบนอุปกรณ์ เพื่อจดจำรูปแบบเสียงพูดของผู้ใช้ คุณสมบัติเหล่านี้ออกแบบมาสำหรับผู้ใช้ที่มีอาการผิดปกติหรืออาการลุกลามซึ่งส่งผลต่อการพูด เช่น สมองพิการ โรคกล้ามเนื้ออ่อนแรง (ALS) หรือโรคหลอดเลือดสมอง โดยจะช่วยยกระดับการปรับแต่งและการควบคุมของผู้ใช้ ซึ่งเป็นการต่อยอดจากคุณสมบัติที่เปิดตัวไปใน iOS 17 สำหรับผู้ใช้ที่พูดไม่ได้หรือเสี่ยงต่อการสูญเสียความสามารถในการพูด

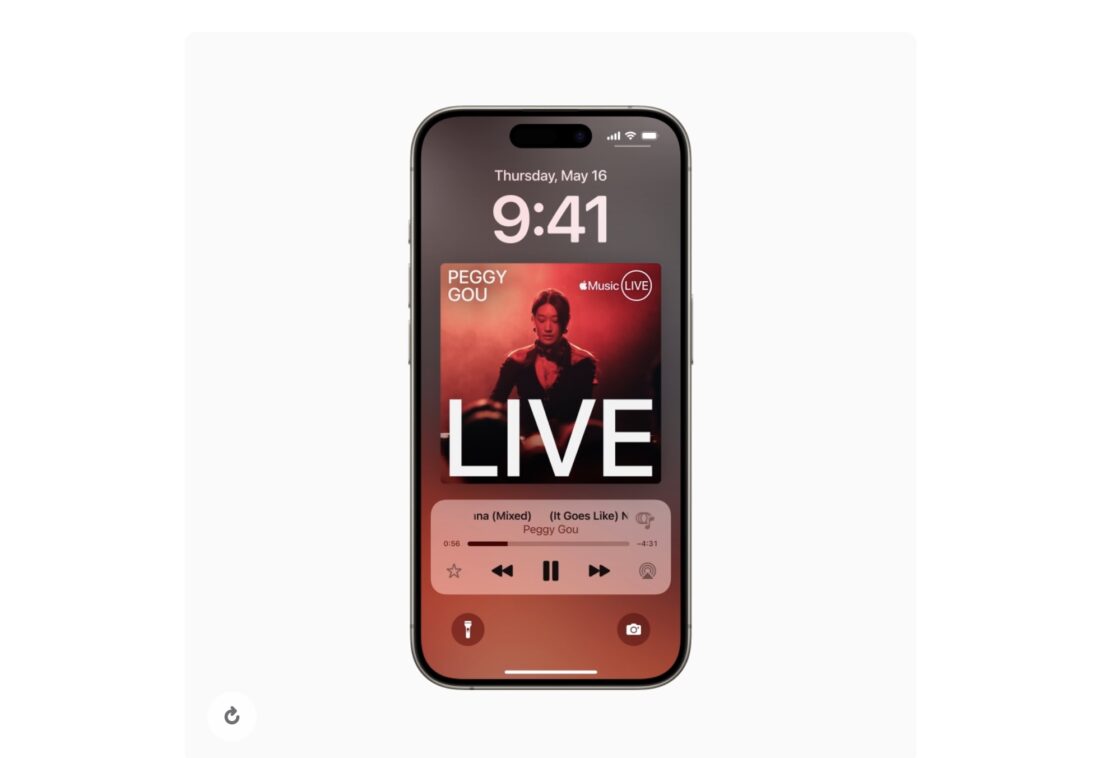

Vehicle Motion Cues ช่วยใช้ iPhone บนรถยนต์ไม่เวียนหัว

รวมถึง Vehicle Motion Cues สามารถช่วยลดภาวะป่วยจากการเคลื่อนไหวหรืออาการเมารถเมื่อใช้ iPhone หรือ iPad ในยานพาหนะที่กำลังเคลื่อนที่ โดยมีจุดเคลื่อนไหวที่ขอบหน้าจอซึ่งแสดงถึงการเปลี่ยนแปลงในการเคลื่อนไหวของยานพาหนะ “เพื่อช่วยลดความขัดแย้งทางประสาทสัมผัสโดยไม่รบกวนคอนเทนท์หลัก”

คุณสมบัตินี้จะใช้เซ็นเซอร์ที่ติดตั้งมาบน iPhone และ iPad จึงสามารถรับรู้ได้เมื่อผู้ใช้อยู่ในยานพาหนะที่กำลังเคลื่อนที่และจะตอบสนองผ่านหน้าจออย่างสอดคล้อง ผู้ใช้สามารถตั้งค่าให้คุณสมบัตินี้แสดงโดยอัตโนมัติบน iPhone หรือสามารถเปิดและปิดในศูนย์ควบคุมได้

สำหรับ CarPlay จะมีคุณสมบัติ การสั่งการด้วยเสียง ฟิลเตอร์สี และการจำเสียง ผู้ใช้สามารถไปยังส่วนต่างๆ บน CarPlay และควบคุมแอปฯ ต่างๆ ได้ ขณะที่ผู้ขับขี่หรือผู้โดยสารที่หูหนวกหรือมีปัญหาในการได้ยินก็สามารถเปิดการแจ้งเตือนเพื่อรับแจ้งเตือนเสียงแตรรถและเสียงไซเรนด้วยคุณสมบัติการจำเสียง และสำหรับผู้ใช้ที่ตาบอดสี ฟิลเตอร์สีจะทำให้อินเทอร์เฟซ CarPlay ใช้งานได้ง่ายขึ้น พร้อมคุณสมบัติการช่วยการเข้าถึงด้านการมองเห็นอื่นๆ เช่น ข้อความตัวหนาและข้อความขนาดใหญ่

ทางด้าน VisionOS คุณสมบัติการช่วยการเข้าถึงที่จะพร้อมใช้งานใน VisionOS ในปีนี้ รวมถึงคำบรรยายสดทั่วทั้งระบบที่จะช่วยให้ทุกคน รวมถึงผู้ใช้ที่หูหนวกหรือมีปัญหาในการได้ยิน สามารถติดตามคำพูดในการสนทนาสดและเสียงจากแอปฯ ต่างๆ ได้ และคุณสมบ้ติใหม่ ๆ อีกมากมาย

ข้อมูลอัปเดตเพิ่มเติม

- สำหรับผู้ใช้ที่ตาบอดหรือมองเห็นไม่ชัด VoiceOver จะมาพร้อมเสียงใหม่ๆ Voice Rotor หรือตัวหมุนเสียงพูดที่ยืดหยุ่น การควบคุมระดับเสียงแบบกำหนดเอง และความสามารถในการปรับแต่งคำสั่งลัดคีย์บอร์ด VoiceOver บน Mac

- แว่นขยาย จะนำเสนอโหมดตัวอ่านใหม่และตัวเลือกในการเปิดโหมดการตรวจจับได้อย่างง่ายดายด้วยปุ่มแอ็คชั่น

- ผู้ใช้อักษรเบรลล์จะมีวิธีใหม่ในการเริ่มต้นและอยู่ในโหมด การป้อนอักษรเบรลล์บนหน้าจอ เพื่อการควบคุมและแก้ไขข้อความที่รวดเร็วยิ่งขึ้น นอกจากนี้ การป้อนอักษรเบรลล์บนหน้าจอยังรองรับภาษาญี่ปุ่น การป้อนอักษรเบรลล์แบบหลายบรรทัดด้วย Dot Pad และตัวเลือกในการเลือกตารางอินพุตและเอาต์พุตที่แตกต่างกันอีกด้วย

- สำหรับผู้ใช้ที่มองเห็นไม่ชัด Hover Typing จะแสดงตัวอักษรที่ใหญ่ขึ้นเมื่อพิมพ์ในช่องข้อความ โดยสามารถแสดงในแบบอักษรและสีที่ผู้ใช้ต้องการได้

- สำหรับผู้ใช้ที่เสี่ยงต่อการสูญเสียความสามารถในการพูด คุณสมบัติ เสียงส่วนตัว จะพร้อมให้บริการในภาษาจีนกลางเร็วๆ นี้ และผู้ใช้ที่มีปัญหาในการออกเสียงหรืออ่านประโยคเต็มๆ จะสามารถสร้างเสียงส่วนตัวโดยใช้วลีที่สั้นลงได้

- สำหรับผู้ใช้ที่พูดไม่ได้ คุณสมบัติ เสียงพูดสด จะมาพร้อมหมวดหมู่ต่างๆ และรองรับการแสดงควบคู่ไปกับ คำบรรยายสด

- สำหรับผู้ใช้ที่มีความบกพร่องทางร่างกาย Virtual Trackpad สำหรับ AssistiveTouch จะช่วยให้ผู้ใช้ควบคุมอุปกรณ์ของตนโดยใช้พื้นที่เล็กๆ ของหน้าจอเป็นแทร็คแพดที่ปรับขนาดได้

- การควบคุมสวิตช์ จะมีตัวเลือกในการใช้กล้องบน iPhone และ iPad เพื่อจดจำการใช้คำสั่งนิ้วในท่าทางต่างๆ แทนสวิตช์

- การควบคุมด้วยเสียง จะรองรับคำศัพท์แบบกำหนดเองและคำที่ซับซ้อน

https://thejournalistclub.com/apple-lgbtq-pride/259611